Сайт

Сайт

Категорія

GPT-3 Alternative Large Language Models (LLMs)Залишилось редагувати: 706

Наступний додаток

BioGPTKoala

Модель діалогу для наукових досліджень від UC Berkeley

Про Koala

UC Berkeley розробила модель діалогу під назвою Koala, яка призначена для наукових досліджень. Результати користувацького дослідження показали, що Koala ефективно відповідає на різноманітні запитання користувачів. Крім того, у половині випадків результати Koala були принаймні такі ж хороші, як у ChatGPT, а зазвичай вони були кращі за модель Alpaca від Stanford. Доступний веб-демо для загального використання.

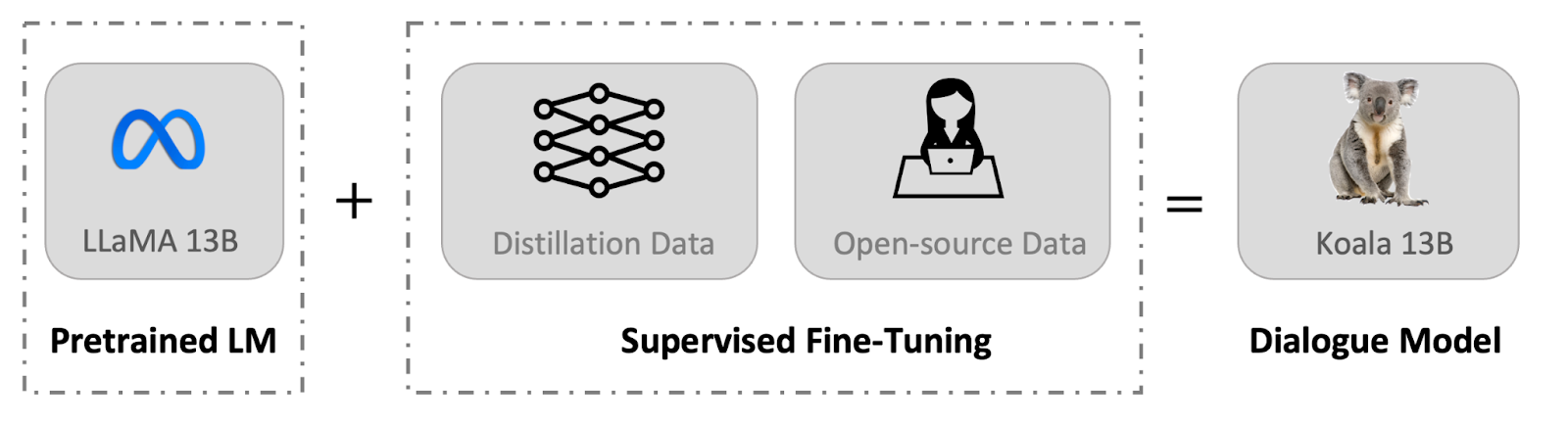

Koala була навчена шляхом доведення до ладу LLaMA від Meta на діалогових даних, зібраних з веб-сторінок, зокрема з фокусом на відповідях на запити інших великих мовних моделей, таких як ChatGPT. Розробники обрали якість над кількістю, тому початковий набір даних з 60 000 діалогів був зменшений до близько 30 000 після усунення зайвих та неанглійських діалогів. Також були використані приклади з ChatGPT та людські відповіді з набору даних HC3 English (87 000 пар питань-відповідей).

Крім того, в навчальну програму Koala були включені відкриті дані з набору даних OIG, набору даних ANthropic HH, набору даних OpenAI WebGPT та набору даних для узагальнення OpenAI.

Джерело: https://analyticsindiamag.com/uc-berkeley-releases-koala-for-research-purposes/

Скріншоти Koala

Читати англійською

Все про GPT-3

Все про GPT-3